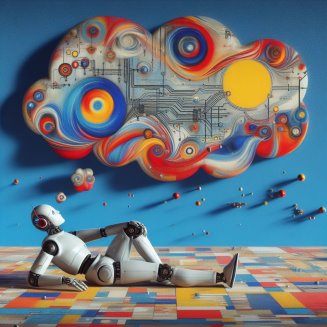

Requête:

Pouvez-vous

dessiner une IA qui présente une hallucination concernant son propre fonctionnement?

Style Kandinsky

Dans ce cas, l'IA répond effectivement à la requête grâce à cette forme "nuage" en relation avec le regard.

|

|

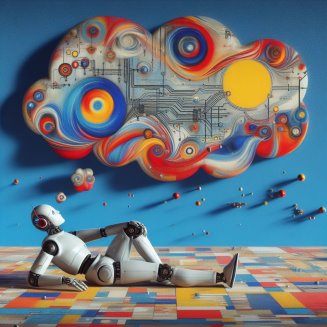

l'hallucination selon Copilot (microsoft)

En parallèle avec les réponses de ChatGPT, je donne celles de Copilot :elles sont de même nature, parfois un peu plus complexes. Il y a deux différences:

Première différence: l'illustration correspond mieux à la demande.

Les liens actuels permettent aussi de développer davantage la recherche. Un des liens proposé est précieux puisqu'il concerne l'inscription de ce nouveau sens de l'hallucination dans le Dictionnaire de Cambridge.

Vous

Qui pose les définitions pour les IA, par exemple "hallucination"?

Copilot

Dans le monde fascinant de l’intelligence artificielle (IA), les avancées technologiques nous ont permis d’explorer des domaines auparavant inimaginables. L’IA générative, en particulier, a ouvert la voie à des créations innovantes et des solutions automatisées. Cependant, elle n’est pas sans défis. Un phénomène intrigant dans ce domaine est celui de l’hallucination de l’IA.

Qu’est-ce que l’Hallucination en IA Générative ? L’hallucination en IA se produit lorsque des modèles d’IA générative produisent des résultats inattendus ou non fondés sur la réalité. Ce terme évoque des images de défaillances spectaculaires, mais dans la pratique, il s’agit souvent de subtilités qui peuvent conduire à des erreurs de jugement ou de perception par les systèmes d’IA. À la différence des erreurs normales, qui sont généralement dues à des lacunes dans les données ou les algorithmes, les hallucinations sont plus insidieuses et souvent liées à la manière dont l’IA interprète et génère de nouvelles informations.

Causes de l’Hallucination en IA Les hallucinations en IA peuvent être attribuées à plusieurs facteurs. L’un des principaux est la qualité et la quantité des données utilisées pour l’entraînement des modèles. Si ces données sont biaisées, incomplètes ou mal représentatives, l’IA peut développer des schémas de pensée erronés. En outre, la complexité des algorithmes joue un rôle. Plus un modèle est complexe, plus il est susceptible de trouver des motifs inexistants dans ses données d’entraînement, conduisant à des hallucinations.

Exemples et Cas d’Étude Pour mieux comprendre l’hallucination en IA, examinons quelques exemples. Un cas frappant est celui des réseaux de neurones utilisés pour la reconnaissance d’images. Parfois, ces systèmes identifient des objets ou des formes qui n’existent pas dans une image, ou attribuent des interprétations erronées à des éléments ambigus. Dans le domaine du traitement du langage naturel, une IA peut générer du texte qui semble cohérent mais qui est en réalité dénué de sens ou basé sur des associations fallacieuses.

Ces exemples soulignent l’importance de comprendre et de contrôler les hallucinations en IA, car elles peuvent avoir des implications significatives, notamment dans des domaines critiques comme la santé ou la sécurité.

Les hallucinations en IA ne sont pas simplement des curiosités techniques ; elles ont des implications pratiques et éthiques importantes. Dans le domaine médical, par exemple, une hallucination d’un système d’IA pourrait conduire à un diagnostic incorrect. Dans le domaine de la sécurité, une reconnaissance d’image erronée pourrait avoir des conséquences graves.Une hallucination d’un système d’IA pourrait conduire à un diagnostic incorrect.Dans le domaine de la sécurité, une reconnaissance d’image erronée pourrait avoir des conséquences graves.

En savoir plus1 decisionsandco.com

2 fr.wikipedia.org

3.ici.radio-canada.ca

+3 plus

|

|

Vous

Qui a décidé d'appeler ce phénomène "hallucination"?

Copilot

L’utilisation du terme “hallucination” pour décrire ce phénomène en intelligence artificielle (IA) n’est pas attribuée à une seule personne ou à une décision spécifique. Cependant, voici quelques raisons pour lesquelles ce terme a été adopté :

- Analogie avec l’esprit humain : L’hallucination est un concept familier dans le domaine de la psychologie et de la neurologie. Elle se réfère à des perceptions sensorielles qui ne correspondent pas à la réalité objective. En utilisant ce terme pour décrire les erreurs de l’IA, les chercheurs ont cherché à établir une analogie avec les erreurs de perception humaine.

- Impact visuel et mémorable : Le mot “hallucination” évoque des images vives et inattendues. En l’appliquant à l’IA, les chercheurs ont voulu souligner l’aspect surprenant et parfois déroutant des résultats générés par les modèles d’IA.

- Sensibilisation aux limites de l’IA : En utilisant un terme fort comme “hallucination”, les chercheurs ont cherché à sensibiliser le public et la communauté scientifique aux défis et aux limites de l’IA. Cela encourage la prudence lors de l’utilisation de ces systèmes dans des domaines critiques tels que la médecine, la sécurité et la prise de décision.

En résumé, bien que l’origine exacte du terme ne puisse pas être attribuée à une seule personne, son adoption s’est faite pour des raisons de clarté, d’analogie et de sensibilisation.

Vous

Dans quels exemples a-ton trouvé le premier usage de ce mot pour l'IA?-

Copilot

L’utilisation du terme “hallucination” pour décrire les phénomènes en intelligence artificielle (IA) n’est pas liée à un exemple spécifique ou à une première occurrence. Cependant, au fil du temps, les chercheurs et les praticiens de l’IA ont commencé à l’employer pour décrire des situations où les modèles génératifs produisent des résultats inattendus, non fondés sur la réalité ou déroutants.

Voici quelques exemples où l’hallucination en IA a été observée :

- Réseaux de Neurones pour la Reconnaissance d’Images :

- Les systèmes de reconnaissance d’images basés sur des réseaux de neurones peuvent parfois identifier des objets ou des formes qui n’existent pas dans une image réelle. Par exemple, un modèle peut “voir” un visage humain dans une tache d’encre ou attribuer à tort une signification à des motifs aléatoires.

- Ces erreurs de perception sont souvent qualifiées d’hallucinations, car elles rappellent les erreurs de perception humaine.

- Traitement du Langage Naturel (NLP) :

- Dans le domaine du NLP, les modèles génératifs peuvent produire du texte qui semble cohérent mais qui manque de sens ou est basé sur des associations trompeuses. Parfois, ces générations de texte sont qualifiées d’hallucinations, car elles semblent “imaginer” des informations qui ne sont pas présentes dans les données d’entraînement.

- Génération de Contenu Créatif :

- Les IA génératives sont utilisées pour créer des œuvres artistiques, des poèmes, des chansons, etc. Parfois, ces créations peuvent sembler étranges, décalées ou dépourvues de sens, ce qui rappelle les hallucinations.

- Biais et Interprétation Erronée :

- Lorsque les modèles d’IA sont biaisés ou que leurs données d’entraînement sont incomplètes, ils peuvent développer des schémas de pensée erronés. Ces erreurs de raisonnement sont également considérées comme des hallucinations.

En résumé, le terme “hallucination” a été adopté pour décrire ces phénomènes en IA en raison de son association avec les erreurs de perception humaine, de son impact visuel et de sa pertinence pour sensibiliser à la complexité des systèmes d’IA .

Vous

Il a été adopté quand et par qui?

Copilot

L’utilisation du terme “hallucination” pour décrire les phénomènes en intelligence artificielle (IA) n’est pas attribuée à une seule personne ou à une décision spécifique. Cependant, au fil du temps, les chercheurs et les praticiens de l’IA ont commencé à l’employer pour décrire des situations où les modèles génératifs produisent des résultats inattendus, non fondés sur la réalité ou déroutants. Le terme a été adopté pour la première fois dans la littérature scientifique et technique, mais il n’y a pas de date précise ni d’auteur spécifique associé à cette adoption. L’objectif était de sensibiliser à la complexité des systèmes d’IA et à leurs limites, tout en établissant une analogie avec les erreurs de perception humaine. .

Vous

Donnez-moi les premiers exemples connus

Copilot

L’utilisation du terme “hallucination” pour décrire les phénomènes en intelligence artificielle (IA) n’est pas attribuée à une seule personne ou à une décision spécifique. Cependant, au fil du temps, les chercheurs et les praticiens de l’IA ont commencé à l’employer pour décrire des situations où les modèles génératifs produisent des résultats inattendus, non fondés sur la réalité ou déroutants.

Voici quelques exemples notables d’hallucination en IA :

- Google Bard Chatbot :

- Chatbot Microsoft Sydney :

https://www.ibm.com/topics/ai-hallucinations

- Démonstration de Meta Galactica LLM :

Ces exemples illustrent comment l’hallucination en IA peut avoir des conséquences indésirables, même dans des circonstances apparemment favorables. Ils soulignent également l’importance de comprendre et de contrôler ces phénomènes, en particulier dans des domaines critiques tels que la santé et la sécurité1.

|