|

|

Requête: |

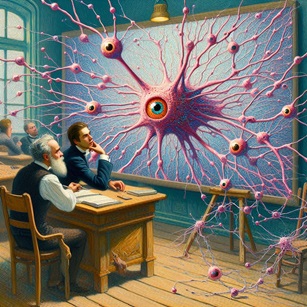

Erreur et vérité: l'hallucination Le neurone à manganèse "Pour l’heure, l’IA hallucine. C’est l’expression consacrée pour rendre compte de la façon dont elle donne des réponses fausses avec un aplomb confondant". Raphaël Gaillard,L'homme augmenté: Futurs de nos cerveaux, Grasset Janvier 2024. Donc un Professeur de psychiatrie utilise (non sans ironie) ce vocabulaire médical pour nous présenter les expressions de l'IA comme si elle était un de ses patients et écrit (2) que "l'IA hallucine" (qu'elle délire donc) et même qu'elle délire "avec aplomb". Ce chemin de la projection anthropomorphique sur ce que fait une IA est une constante, ce que R.Gaillard confirme puisque il nous dit que cette expression "hallucination" pour parler des erreurs est l'expression consacrée (3) quant il s'agit des erreurs des IA. Il tempère ce diagnostic, mais toujours en proposant des équivalents humains pour nommer la manière dont l'IA a traité le "problème" qui lui a été posé: « Dans la clinique psychiatrique, on parlerait plutôt de "confabulations" [un « trouble de la mémoire qui se manifeste comme une fabulation dite "compensatrice" des lacunes amnésiques », selon Le Larousse], explique Raphaël Gaillard, responsable du pôle de psychiatrie de l’hôpital Sainte-Anne. De façon curieuse, quand il manque une connaissance à une IA générative comme ChatGPT, elle l’invente ».(3) Pour continuer à élucider ce que j'en pense moi-même, j'ai donc suivi les deux voies:

|

En inventant le neurone à manganèse, L'IA aurait compensé une lacune amnésique. Là encore la pensée projective nous joue des tours car dans les suites de token(4) qui se sont créées au fur et à mesure des apprentissages de l'IA, tout serait matériellement en contiguités et couches successives (90 couches pour GPT4).L'IA peut rencontrer des absences de données, des insuffisances de données, mais pas avoir oublié des données. Interrogé, Copilot décrit ainsi cette situation :"à la différence des erreurs normales, qui sont généralement dues à des lacunes dans les données ou les algorithmes, les hallucinations sont plus insidieuses et souvent liées à la manière dont l’IA interprète et génère de nouvelles informations".Devant l'expression "neurone à manganèse", l'IA n'a pas rejeté le prompt, on peut donc supposer qu'aucun de ses algorithmes ne lui a interdit de répondre à cette demande farfelue (ce qui arrive parfois).Contrainte de sortir une réponse, elle a donc parcouru les éléments disponibles de "tout ce qui concerne neurone" dans la matérialité de ses données" jusqu'à "renconter" quelque chose qui concerne l'élément "manganèse" le plus à proximité de "neurone". Elle a illico combiné entre eux les éléments qu'elle a trouvé sur les diverses chaines convoquées et obtenu ce résultat absurde. Absurde, mais la réponse fausse n'est pas rien : elle trace une sorte de lien qui n'existait pas et n'avait aucune chance d'exister dans une définition humaine entre ces deux termes, lien qui maintenant va pouvoir être corrigé et c'est bien ce qui a eu lieu car voilà ce que j'obtiens quand je pose maintenant la même question: ChatGPT Un "neurone à manganèse" n'est pas un terme couramment reconnu dans les domaines de la neurologie ou de la biologie. Il semble qu'il puisse y avoir confusion ou une erreur de terminologie. Le manganèse est un élément chimique qui, en certaines quantités, est essentiel pour le fonctionnement sain du corps humain, y compris le bon fonctionnement du cerveau. Cependant, une exposition excessive au manganèse peut entraîner des problèmes neurologiques, car il peut s'accumuler dans le cerveau et affecter le fonctionnement des neurones. Comme pour mon premier exemple d'erreur, le piège tendu à l'IA s'est apparemment transformé en un "surcroit d'apprentissage".Est-ce un effet durable , il est bien difficile de le dire sans autre expérience. | |

1. Comme je lis cet ouvrage dans sa version Kindle, je ne peux pas indiquer la page de cette citation.

2. Beaucoup de publications avant ce livre ont utilisé cette expression "hallucination", je vais en dire quelque chose plus tard en interrogeant directement GPT4 et Copilot

3. "consacré" est le mot juste puisque le Dictionnaire de Cambridge a introduit fin 2023 une nouvelle définition de l'hallucination pour désigner un certain type d'erreur des IA.

Définition ajoutée du mot « hallucinate » en 2023 :

Lorsqu'une intelligence artificielle (un système informatique qui possède certaines des qualités du cerveau humain, comme la capacité de produire du langage d'une manière qui semble humaine) hallucine, elle produit de fausses informations.

4. Laure Beaudonnet :Hallucinations, délires… Une IA peut-elle péter les plombs (comme un humain) ? 20Minutes 30/01/2024

5."la machine opère avec des unités nouvelles, mots ou fragments de mots, qui ne respectent pas l’ordre naturel de la parole dans une phrase. Un token est une association libre d’éléments du langage. Il peut s’agir de morphèmes comme les préfixes et les suffixes, de mots proches ou éloignés ou de bouts de phrases. Dans les sous-variantes répandues de transformers, la plupart des tokens contiennent des éléments qui ne se suivent pas dans une phrase et n’ont pas de lien évident entre eux. Casser l’ordre séquentiel et les limites des mots, combiner des petits éléments d’un texte pris ici et là : c’est l’idée principale de la tokenisation du langage." Alexei Grinbaum : Parole de Machines Dialoguer avec une IA HumenSciences mars 2023 version Kindle.